Jak zainstalować lokalny LLM – krok po kroku

Wyobraź sobie, że możesz korzystać z potężnego modelu językowego… bez dostępu do internetu! Brzmi futurystycznie? A jednak to możliwe – dzięki lokalnym LLM-om, które działają na Twoim komputerze, chroniąc Twoją prywatność i dając Ci pełną kontrolę nad danymi.

W świecie, gdzie przetwarzamy wrażliwe informacje klientów, prywatność nie jest luksusem – to konieczność. A gdy dowiesz się, że możesz to osiągnąć jednym kliknięciem? Będzie jeszcze lepiej!

W tym artykule pokażę Ci, jak zainstalować lokalny LLM, dlaczego polecam LM Studio, który model wybrać, czym są parametry i jak z tego korzystam na co dzień na moim MacBooku Air M2 z 8GB RAM.

Spis treści

Co to jest lokalny LLM i dlaczego warto go używać?

Lokalny LLM to model językowy uruchamiany bezpośrednio na Twoim komputerze, bez potrzeby łączenia się z internetem czy zewnętrznymi serwerami. Co to oznacza w praktyce?

- Prywatność – Twoje dane, pytania, dokumenty, zapytania klientów – wszystko zostaje na Twoim komputerze.

- Pełna kontrola – nie musisz ufać zewnętrznym API. Sam decydujesz, co się dzieje z danymi.

- Brak opóźnień – odpowiedzi generowane są lokalnie, błyskawicznie, bez względu na jakość łącza.

- Bezpieczeństwo – brak ryzyka wycieku danych do chmury czy przetwarzania przez zewnętrzne firmy.

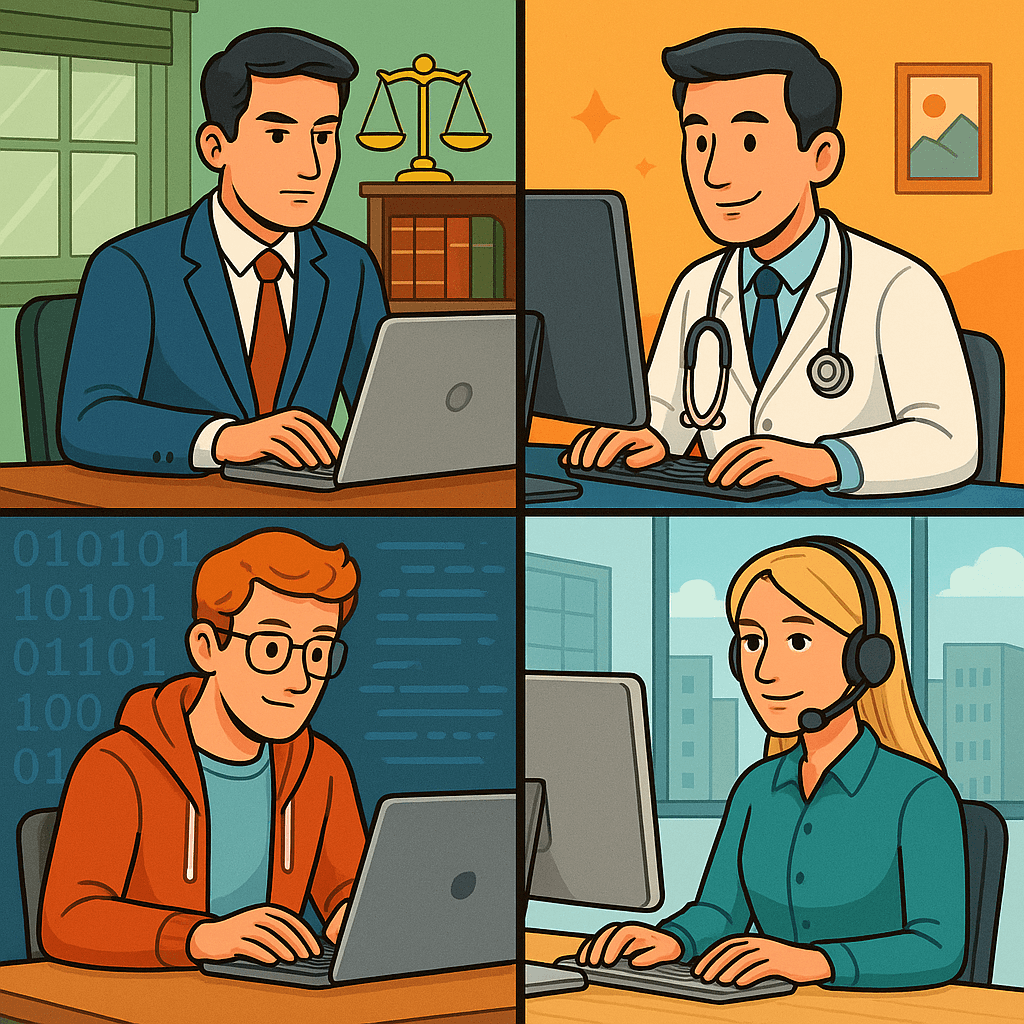

Dla wielu specjalistów, w tym prawników, marketerów, freelancerów i programistów, to gamechanger.

Jak zainstalować lokalny LLM – krok po kroku

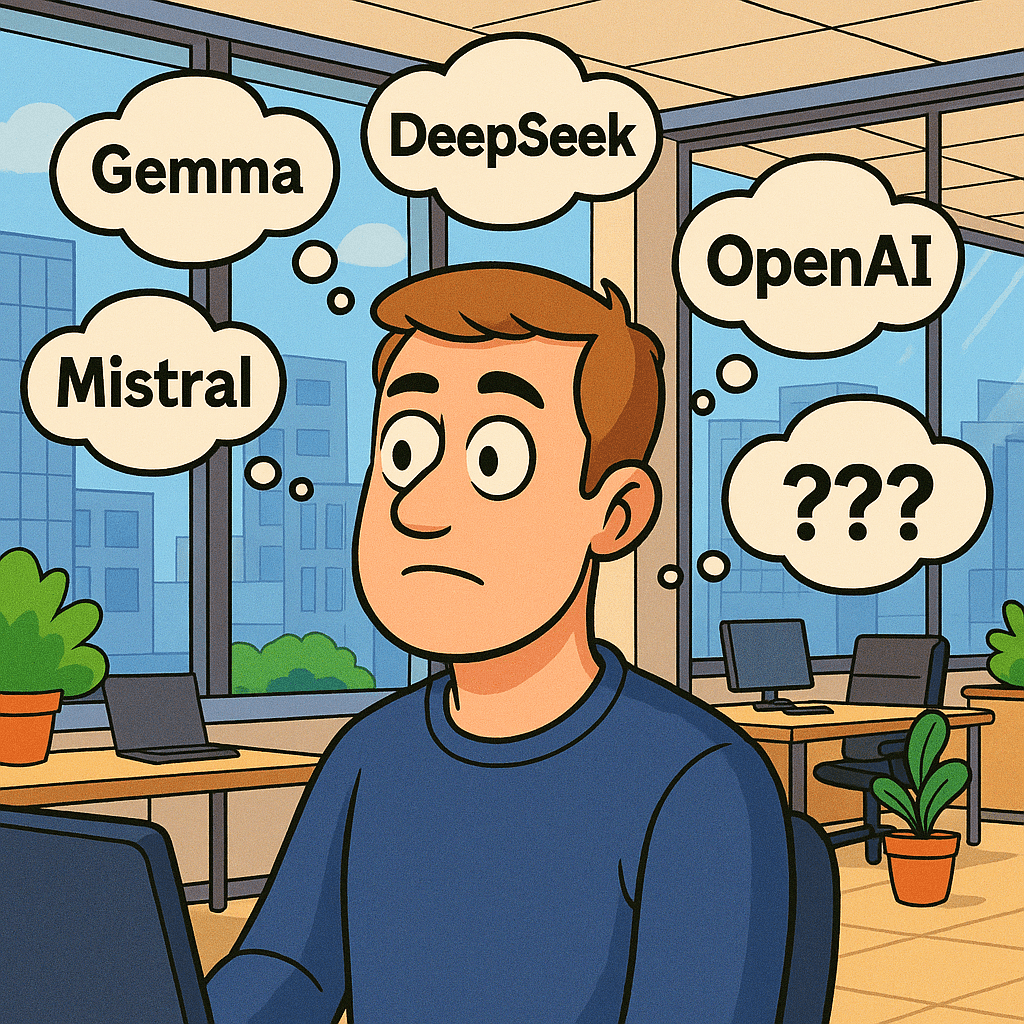

Jest kilka sposobów na uruchomienie lokalnego LLM. Popularne rozwiązania to np. Ollama, LocalAI czy GPT4All, jednak z mojego doświadczenia mogę z czystym sumieniem polecić LM Studio.

Dlaczego LM Studio?

Bo to najprostsze i najwygodniejsze narzędzie, jakie testowałem. Proces instalacji wygląda dokładnie tak:

- Pobierasz aplikację z oficjalnej strony LM Studio – wersje są dostępne na Windows, macOS i Linux.

- Instalujesz ją jak każdą inną aplikację desktopową.

- Po uruchomieniu masz dostęp do przeglądarki modeli – znajdziesz tam m.in.:

- DeepSeek (do generowania tekstu),

- Mistral,

- LLaVA (multimodalny – obraz i tekst),

- Flux (generowanie grafiki na podstawie promptów tekstowych).

- Wybierasz model i instalujesz go jednym kliknięciem. Tak, to naprawdę takie proste.

Ale zanim to zrobisz – warto dobrze przemyśleć, jaki model wybrać.

Jak wybrać odpowiedni model? Na co zwrócić uwagę?

Modele LLM różnią się od siebie nie tylko jakością odpowiedzi, ale też rozmiarem i wymaganiami sprzętowymi. Kluczowy parametr, na który trzeba zwrócić uwagę, to tzw. liczba parametrów modelu, wyrażana w miliardach (np. 4B, 7B, 13B, itd.).

Czym są te „parametry”?

W skrócie – to liczba wag sieci neuronowej, które model wykorzystuje do „rozumienia” i generowania tekstu. Więcej parametrów = większa moc obliczeniowa i lepsze wyniki… ale też większe zużycie zasobów komputera.

Jak dobrać model do komputera?

- 4B–7B – idealne dla laptopów i komputerów domowych, bez dedykowanej karty graficznej (CPU-only).

- 13B–30B – wymagają mocniejszego sprzętu, najlepiej z dedykowaną kartą GPU (np. RTX 3060 i wyżej).

- 65B i więcej – dla zaawansowanych użytkowników z potężnym sprzętem lub do uruchomienia na serwerach.

Mój wybór – Gemma 3 4B: lekki i skuteczny model od Google

Osobiście zdecydowałem się na Gemma 3 4B – to model opracowany przez Google, trenowany na architekturze Gemini, zoptymalizowany do działania lokalnego. Dlaczego go polecam?

- Świetnie radzi sobie z językiem polskim – odpowiada naturalnie, bez dziwnego stylu czy błędów gramatycznych.

- Jest lekki – potrzebuje niewiele RAM-u i mocy procesora.

- Działa bez problemu na moim MacBooku Air M2 z 8GB RAM – bez żadnych crashy czy lagów.

- Gotowy do działania od razu po instalacji – żadnej konfiguracji.

Dla osób, które dopiero zaczynają przygodę z lokalnymi LLM, Gemma 3 4B to naprawdę solidny punkt startowy.

LM Studio – Dodatkowe funkcje, które pokochasz

To, co wyróżnia LM Studio, to nie tylko łatwość instalacji. Program oferuje również bardzo przydatne funkcje, które sprawdzają się w codziennej pracy:

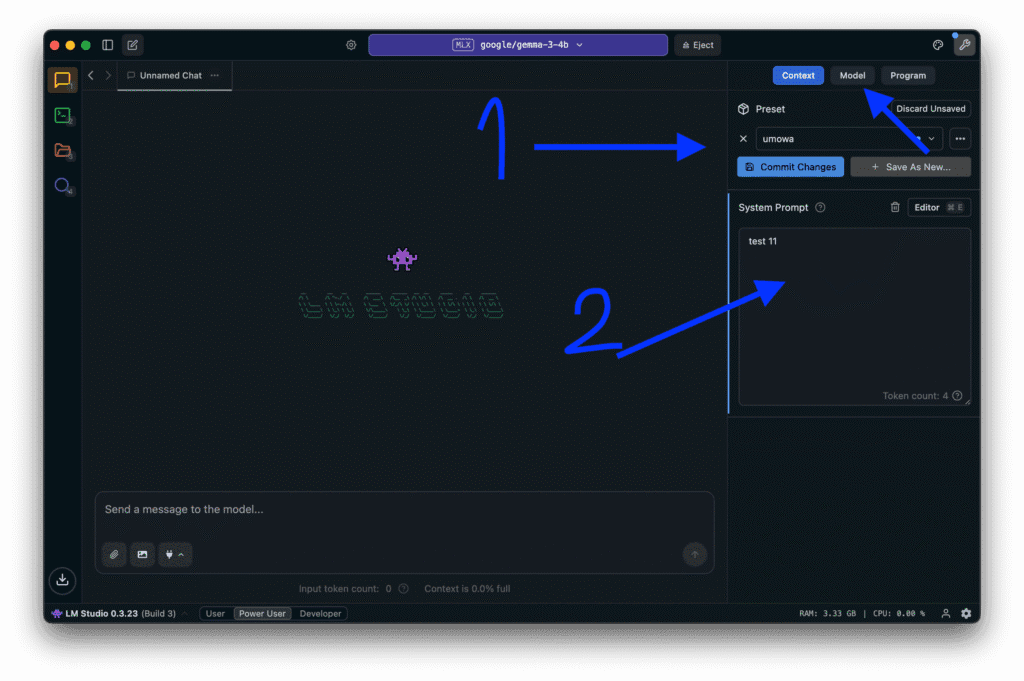

1. Prompty systemowe

Możesz ustawić globalny „kontekst”, w którym działa Twój model. Np. „Jesteś prawnikiem, który generuje umowy dla klientów.”

2. Presety (zestawy zadań)

Możesz stworzyć różne profile użytkowe, np.:

- jeden do generowania umów,

- inny do odpowiadania na maile według Twojej bazy wiedzy (RAG),

- jeszcze inny do kreatywnego pisania lub kodowania.

Nie musisz za każdym razem ustawiać wszystkiego od zera – wystarczy kliknięcie.

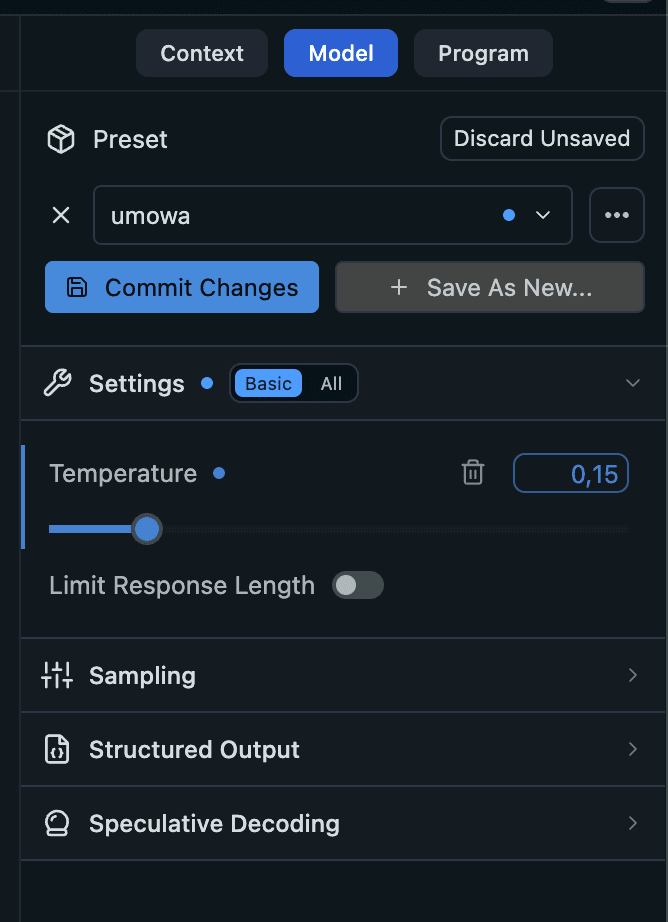

Oprócz tego oczywiście możemy także zarządzać temperaturą i innymi ciekawymi funkcjami. Zerknij w zakładki obok tj. model:

Dla kogo lokalny LLM to must-have?

Z mojego doświadczenia, lokalny LLM idealnie sprawdza się u:

- Freelancerów – tworzenie treści, maili, dokumentów offline.

- Prawników – generowanie dokumentów z wrażliwymi danymi.

- Specjalistów IT i marketerów – analiza tekstu, testowanie promptów.

- Firm i agencji – przetwarzanie danych bez ryzyka ich ujawnienia.

Jeśli masz do czynienia z informacjami, które nie powinny „wypływać” z Twojego komputera – lokalny LLM to rozwiązanie, które powinieneś rozważyć.

Podsumowanie – Pełna kontrola i wygoda dzięki lokalnemu LLM

Lokalne LLM-y to prawdziwa rewolucja w świecie AI. Dzięki nim zyskujesz:

- pełną prywatność,

- niezależność od internetu,

- natychmiastowe odpowiedzi,

- i ogromną elastyczność dzięki narzędziom takim jak LM Studio.

W moim przypadku, połączenie Gemma 3 4B i LM Studio okazało się idealne – działa płynnie na MacBooku Air M2 i naprawdę zmieniło sposób, w jaki pracuję.

Nawiasem mówiąc – tak podkreślam z jakiego sprzętu korzystam, aby pokazać, że nie ejst to sprzęt za 20 000 zł tylko na dzisiejsze standardy dobry laptop do pracy biurowej.

Nie czekaj – sprawdź sam, jak wygląda przyszłość AI… bez chmury.